Abstract

Il dilemma di Collingridge nel suo approccio relativo al rapporto tra tecnologia e società può essere sfruttato, in ambito medico-legale, nelle strategie di risk-management basate sull’Intelligenza Artificiale per la prevenzione e la gestione dell’errore in ambito sanitario. Ce ne parlano la Prof.ssa Rossana Cecchi, Ordinario di Medicina Legale dell’Università di Parma e Tudor Mihai Haja.

. . . .

Il dilemma di Collingridge

Il Dilemma di Collingridge è un problema etico ed epistemologico relativo al rapporto tra tecnologia e società. È stato formulato per la prima volta dal filosofo David Collingridge nel suo libro del 1980 intitolato “The Social Control of Technology“.

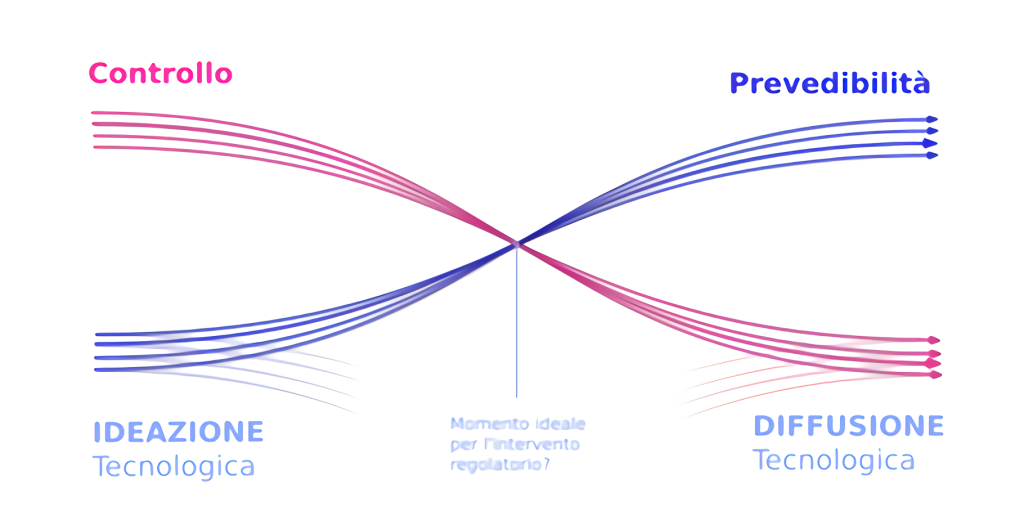

Il dilemma sostiene che in fase di sviluppo di una tecnologia, le conseguenze sociali ed ambientali della sua applicazione possono essere difficili da prevedere in quanto le informazioni sui possibili sviluppi sono limitate. Tuttavia, una volta che la tecnologia è stata ampiamente adottata, i suoi effetti diventano più evidenti, ma è troppo tardi per governarli senza un elevato sforzo regolatorio.

Si evidenzia così la difficoltà di conciliare uno sviluppo innovativo libero con uno scenario di effettiva tutela della società da potenziali effetti nocivi imprevedibili.

Il tema è nato agli albori dello sviluppo di Internet, uno scenario in cui non era assolutamente possibile predire gli effetti negativi che tale tecnologia avrebbe potuto portare con sé. Fenomeni come cyberbullismo, phishing, furto di dati personali o inferenze nella vita democratica di altri Paesi, sono oggi per noi – forti del “senno di poi” – evidenti o, perlomeno, comprensibili in quanto a dinamiche che li hanno fatti scaturire e la loro portata.

Allo stesso modo in cui 40 anni fa si trattava di concetti inimmaginabili, oggi ci troviamo a dover regolare processi di cui non conosciamo e non possiamo immaginare del tutto la direzione che prenderanno e le problematiche che ne deriveranno.

Da qui l’attualità del Dilemma di Collingridge se rapportato allo sviluppo dell’Intelligenza Artificiale in generale, ma soprattutto a quella applicata all’ambito sanitario; essendo quest’ultimo potenzialmente quello con maggiore impatto sulla salute – intesa in senso olistico – dell’umanità.

Ci vengono incontro le strategie messe sinora in atto per evitare il dilemma di Collingridge.

La prima si concentra sull’anticipazione dei possibili impatti futuri della tecnologia, attraverso l’approccio della “valutazione prospettica“, che cerca di prevedere le implicazioni future della tecnologia prima di metterla a disposizione, al fine di poter affrontare i problemi emergenti in tempo. Questo approccio considera lo sviluppo tecnologico come un processo evolutivo esposto ad un ambiente di selezione costituito da mercati, leggi e regolamenti. Le tecnologie che riescono ad imporsi sono, di conseguenza, quelle che riescono a soddisfare – oppure a sfuggire – le regolamentazioni e le esigenze dei mercati.

La seconda, invece, si basa sulla regolamentazione del processo di innovazione, anziché sull’anticipazione dei suoi effetti. L’approccio della “sperimentazione socio-tecnologica” ne è un buon esempio. Invece di speculare su un futuro incerto, questo approccio propone di accettare l’incertezza e di considerare le innovazioni come “esperimenti sociali” che richiedono un’etica per essere condotti in modo responsabile. Ne deriva che, invece di cercare di prevedere il modo in cui le tecnologie – inevitabilmente – cambieranno la società, dovremmo regolamentare responsabilmente i processi di innovazione.1

Tornando al dilemma originale, e semplificando la problematica all’estremo questa si divide in:

- Problema di informazione: l’impatto della tecnologia non è prevedibile a priori.

- Problema di controllo: i cambiamenti o le regolamentazioni sono difficili a posteriori.

.

.

IA e metodo medico-legale

Se a questo punto lo analizzassimo secondo i criteri del metodo medico-legale, si potrebbe azzardare un parallelismo con la metodologia del risk-management in ambito clinico. Esso può infatti essere distinto in due approcci analitici diversi e complementari: quello pro-attivo la prima strategia e quello re-attivo la seconda.

L’approccio reattivo, più “classico”, si concentra sulla risposta a effetti già verificatisi. Parte da un evento avverso e ricostruisce a ritroso la sequenza degli eventi con l’obiettivo di identificare i fattori che hanno causato o contribuito al verificarsi di un evento. Valuta il danno e la sua causa attraverso la ricostruzione dell’evento con una metodologia accurata in 13 fasi, e valuta il nesso causale tra le condizioni iniziali, una condotta conseguente e i suoi effetti. Questa metodologia, adottata a linea guida europea in ambito medico-legale per la valutazione della responsabilità medica (vedi), può essere adattata all’IA applicata allo scenario sanitario e utilizzata per la valutazione dei problemi di responsabilità.

L’approccio proattivo, invece, è una strategia di gestione del rischio “prima dell’evento“. In questo caso, l’attenzione si concentra sulla prevenzione dei rischi e sulla mitigazione dei loro effetti prima che si verifichino. Si cerca quindi di prevedere per ogni singola fase gli errori che possono verificarsi durante l’esecuzione e di valutare il rischio ad essi associato. Questo approccio può beneficiare della legge universale, della legge statistica o del criterio della credibilità razionale, previsto dalla metodologia medico-legale, che cerca tutti i possibili errori che possono verificarsi, ne definisce le modalità e ne valuta la frequenza, classificando gli errori in base alla loro probabilità, alla loro gravità e alla probabilità di essere rilevati. L’approccio proattivo definisce il livello di rischio in base alle categorie precedenti.

Emerge quindi uno scenario in cui la Medicina Legale, abituata a lavorare in modo complementare tra criteri causali a posteriori e criteri preventivi a priori, può essere di grande aiuto nel cercare di conciliare i due aspetti, apparentemente contrastanti, evidenziati da Collingridge. L’argomento merita ulteriori approfondimenti e sarà sicuramente preso in considerazione come possibile chiave di lettura per gli scenari futuri.

VUOI APPROFONDIRE QUESTO ARGOMENTO?

Leggi anche: Danno a persona e intelligenza artificiale: parla il Presidente Zoja con un intervento del Prof. Pomara